从业务角度理解深度学习及其应用

近几年,深度学习在图像、音频处理等领域得到了广泛的应用并取得了骄人的成绩,本文根据笔者的工作实践,谈谈对深度学习理解,以及我们的应用和经验。文章涉及的很多结论,是笔者个人的理解和不充分实验的结果,所以难免谬误,请读者不吝指正。

机器学习就是学习对象的表示

“机器学习/深度学习模型依靠左右互搏,可以迅速达到很高的智能水准。”、“人工智能/深度学习能毁灭人类的奇点即将来到!” 网络上经常出现这类观点,让笔者非常惊讶。而让笔者更惊讶的是,很多人居然相信了。那么,什么是机器学习呢?

机器学习的对象是我们生活中所接触到的一切事物,这些事物包含自然界的事物,以及人类抽象出来的概念。笔者认为,机器对于这些对象的学习,本质上是使用机器语言对其特征进行表示。例如,对性别的识别,其实就是计算机将样本表达成男/女两种形式。

目前的计算机是以CMOS管为基础的冯诺依曼结构,其运算是线性的,数据的表达是0维度的。如何让低维度的计算机处理高维度的对象?这个表示的过程其实就是机器学习的过程。就如同处在二维空间的蚂蚁无法感知三维世界一样(图1),笔者认为目前的计算机0维的运算结构无法真正实现类似人类智能的人工智能,因为这种表示是不充分的。

图1 二维空间的蚂蚁无法感知三维世界

比如,自然界中的事物有其独特的属性,同时是相互关联的,这些规律有的被人类发现,有的则依旧未知,同时数字的表达能力是有限的。如图2所示,这个是英国地图的轮廓,如果使用数字只能够去逼近,但永远无法进行准确描述。

图2 英国地图的轮廓

我们使用计算机对每个事物进行二进制编码可以区别每个事物,但却忽略了事物的属性以及相互之间的关联性。机器学习则是在人为设定的规律前提下,寻找对事物的表示,并一定程度上保留这种关联性。

从宏观上看,笔者认为目前多数的人工智能可以视为一个表示和索引的过程:机器学习完成了表示,人工智能部分就是基于表示的索引。根据目标,我们可以用多种方法,将对象表达成多种数学结构、数字、向量、矩阵等等。下面就是对这些表达式进行存储,这些表达式具有明确的意义,比如男女分类中表达式就是(0,1),(1,0)分别表示男女两种模式。当一副照片进行预测时,首先我们需要寻找其表达式(0.3,0.7),在存储的模式中索引其表达的意义。

深度学习简述

简单地说,深度学习就是使用多层神经网络对对象进行表达。当然这里面衍生出了很多的具体技术和方法。下面简要介绍深度学习里面常用的概念和典型的网络,这些会在后续的项目实践中涉及。

卷积神经网络(Convolutional Neural Networks, CNN)

CNN是对传统的神经网络的简化。举个例子,1,000×1,000的图像,如果隐含层数目与输入层一样,即也是1,000,000时,那么输入层到隐含层的参数数据为1,000,000×1,000,000=10^12,当隐层不止一层,参数将是一个巨大的量级,现实中我们的硬件资源是有限的,所以引入了卷积神经网络。

卷积神经网络使用卷积核实现了两个目的:1.减少参数;2.对空间进行编码。

如何减少参数?

-

采用局部连接取代全连接,即全局相关变成局部相关。基于这样一个现实,图片中像素点之间是存在空间相关性的,强度跟间距成负相关。所以笔者认为局部化实质上是相关性较弱的远处像素点,所以存在性能的损失。

-

共享参数,基于这样的假设,相同距离的像素点之间的相关性相同,当然这也是一种无可奈何的折中。

循环神经网络(Recurrent Neural Networks, RNN)

RNNs的目的使用来处理序列数据,RNNs会对前面的信息进行记忆并应用于当前输出的计算中,即隐藏层之间的节点不再无连接而是有连接的,并且隐藏层的输入不仅包括输入层的输出还包括上一时刻隐藏层的输出。

RNNs已经被实践证明对NLP是非常成功的,如词向量表达、语句合法性检查、词性标注等。在RNNs中,目前使用最广泛、最成功的模型便是LSTMs(Long Short-Term Memory,长短时记忆)模型。

神经网络的反馈算法

神经网络依靠反馈算法进行参数调整,实现将对象转化成所预期的数学表示。

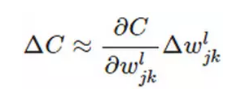

那么更新方程为:

上面是一个标准的偏微分的公式,一层一层地推导,又可以表示为:

上面是一个标准的链式偏微分公式。

损失函数

说到了损失函数(loss)函数,简单的讲就是对上面所说的规律的表达。下面简述下几个用过的损失函数和其特性。

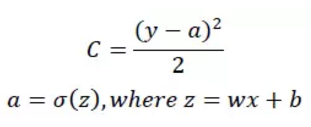

方差损失函数

比如对于一个神经元(单输入单输出,sigmoid激活函数),定义其损失函数为:

y是我们期望的输出,a为神经元的实际输出。

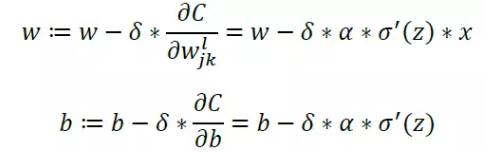

在训练神经网络过程中,我们通过梯度下降算法来更新w和b,因此需要计算损失函数对w和b的导数:

如何更新w和b,才能使C减小?

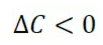

即

由于

故使

时,

可以保证C始终减小(平方始终大于等于0),所以w和b的更新公式为:

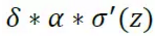

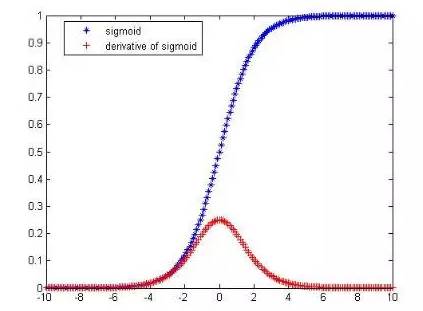

因为Sigmoid函数所具有的性质,导致

在z取大部分值时会很小(如图3标出来的两端,几近于平坦),这样会使得w和b更新非常慢(因为

这一项接近于0)。

图3 Sigmoid函数

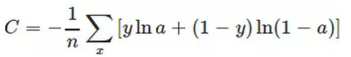

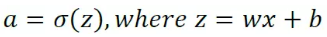

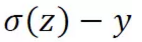

交叉熵损失函数(cross-entropy cost function)

为了克服这个缺点,引入了交叉熵损失函数(下面的公式对应一个神经元,多输入单输出):

其中y为期望的输出,a为神经元实际输出

当真实输出a与期望输出接近y的时候,损失函数接近于0。另外,它可以克服方差损失函数更新权重过慢的问题。我们同样看看它的导数:

可以看到,导数中没有

这一项影响,即受误差的影响。所以当误差大的时候,权重更新就快,当误差小的时候,权重的更新就慢。这是一个很好的性质。

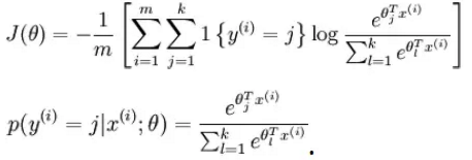

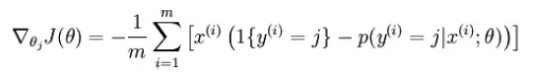

对数似然函数(log-likelihood cost)

深度学习中进行分类普遍的做法是将softmax作为最后一层,此时常用的是损失函数是log-likelihood cost。

Logistic回归用的就是Sigmoid函数,softmax回归是Logistic回归的多类别推广。log-likelihood损失函数在二类别时就可以化简为交叉熵损失函数的形式,其中y可以取k个不同的值。因此,对于训练

我们有

损失函数为:

其中,

是模型的参数。

这一项对概率分布进行归一化。

经过求导,我们得到梯度公式如下:

调参技巧

网络设计好后,训练网络,进行调参是重头戏了。调参可以调节的参数很多,这里主要讲讲学习速率(η)和正则项系数(λ)和Batch Size。

学习速率

学习速率太小,则会使收敛过慢,如果学习速率太大,则会导致损失函数振荡。在训练过程中,可变学习率可以取得更好的效果。

正则项系数

在确定好learning rate后,给λ一个值(比如1.0),然后根据validation accuracy,将λ增大或者减小10倍(增减10倍是粗调节,当你确定了λ的合适的数量级后,比如λ = 0.01,再进一步地细调节,比如调节为0.02,0.03,0.009之类。)

Batch size

batch数太小,而类别又比较多的时候,真的可能会导致loss函数震荡而不收敛,尤其是在网络比较复杂的时候。Batch size太大,可以较快的收敛,但学习到的网络精度会比较低。一般根据GPU的内存,选择8的倍数,然后是稍微大一点。

深度学习在图像弱监督学习中的应用

这里采用项目的方式谈谈笔者在使用CNN网络对图像进行处理的一些工作和总结。

监督学习的方式存在以下的一些先天缺陷:

-

机器学习的结果的优劣很大程度上取决于数据的数量和质量。这意味数据的准备需要进行大量的人工标注工作。标注的质量,即使在预先设定的有限类别内,准确性也是因人而异的。

-

把图像理解转换为解决特定的有限类别的分类,使得训练出来的模型仅仅适用于有限类别的分类。比如,人脸识别的模型就难以去识别大猩猩的脸,即使他们很像,在不同的应用场景必须训练不同的网络。

互联网上存在大量的图片和文本,观察发现,这些图片和围绕其的文本都是存在相关性的。基于这种相关性,其实也可以实现无监督或弱监督学习。这里要介绍的,就是一个笔者提出并实现的弱监督图像理解算法–Image2Words。

算法简述

图4 模型训练示意图

使用CNN网络对图像进行特征提取,同时使用CNN网络对文字进行表示,最小化对应文字和图像的误差。所以,模型分为两个部分,分别是对应文字和图像。

图片对应的网络包含5个group的卷积、2层全连接图像特征、一层全连接分类特征记为image_fc。文字包含的网络采用一个卷积,1层全连接分类特征记为word_fc。保证图片和其对应的文字的全连接的分类特征输出最相似。

模型的应用

Image2Words作为图片特征抽取模块,实现基于图片进行商品检索和分类功能。深度特征与传统的图像特征对图像的描述侧重点不同,前者尤其高层网络的特征更加着重在类别描述,而SIFT特征则是对局部特定的形状进行描述。

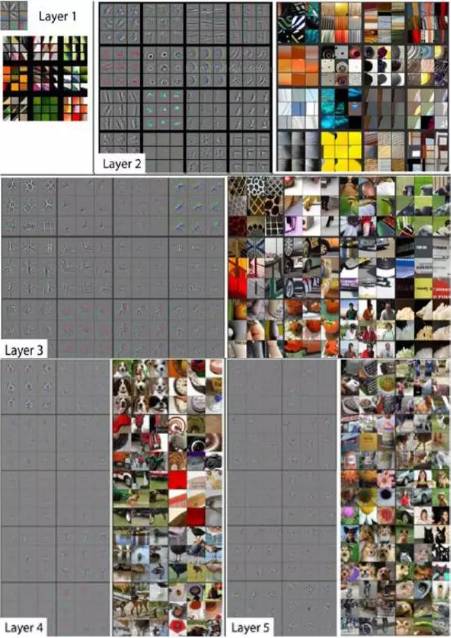

图5是《Visualizing and Understanding Convolutional Networks》里面的一张每层输出的可视化结果。

图5 卷积网络的可视化

从图5可以看到,底层的特征是非常局部的颗粒化特征;层数越高,特征表现越全局化。在图像特征抽取时,可以适当的使用低层特征以增加图片细节信息。

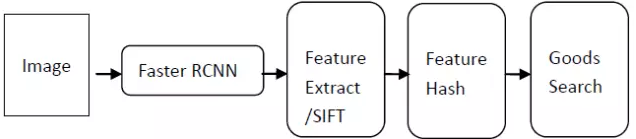

相似商品检索

整体的流程如图6,先使用Faster-RCNN进行箱包检测并截取,采用Image2Words提取截取的箱包图片特征,对特征进行Hash操作,在商品库中对Hash后的Feature进行匹配,找到得分最高的商品信息。

图6 相似商品检索流程

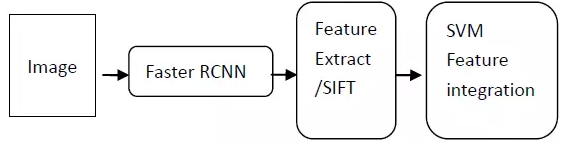

相同商品判别

同品判断的流程跟上面差不多,只是最后训练SVM或其他分类器进行特征融合,如图7。

图7 同品判别流程

使用SVM对特征进行融合,并进行同品校验对于像商品,人脸校验和色情图片识别的这类正负样本不均衡的分类问题,如何去选取“边界样本”非常重要。在实现过程中,直接选择loss比较大的Pair来构建样本,效果也不错。

效果展示

图像理解

下面来看看这种弱监督学习后的网络对图像理解能力。给出的理解词汇中,笔者过滤掉了人名,并只展示部分得分较高的词汇。测试图片源自网络,并不包含在训练样本中。同时给出该图片在国内外知名搜索引擎的检索结果,作为对比。图片下方的单词是Image2words给出的结果。

图8 食物图像理解对比

图9 人像图像理解对比

图10 装车图像理解对比

对比上面三幅图,国外搜索引擎对三幅图的理解都失败了,国内搜索引擎给出了最后一幅图中包含轿车的结果。Image2word给出的信息量相比于目前两大搜索引擎的算法要丰富得多。

基于Image2Words模型的以图搜图

如图11所示,是基于Image2Words模型的以图搜图的结果。

图11 基于Image2Words模型的以图搜图

深度学习在个性化推荐中的应用

推荐系统本质上是预测用户意图。意图是基于当前所有因素的规律性反应。意图具有不可预测性:影响意图的因素繁多,很多难以探知。比如饿了是肠胃的状态在脑中的反馈,不易探知。饿了跟上次吃饭的时间、饭量、吃饭的内容、期间的消耗、个人体质等等因素相关,这些因素是难以探知的。现实推荐中,我们忽略不可知和难以探知的因素,根据已掌握信息可以一定程度上实现意图预测。

推荐系统建模

推荐系统涉及的对象主要有两个,推荐对象(User)和推荐内容(Item)。根据信息的可获知性和时变性,将User和Item划分成三部分构成,静态信息、动态信息和未知信息,如图12所示。User和Item的共同作用产生了当前的具体的行为,这里称这个模型叫做多维度模型。

图12 多维度模型

图12中,User_S表示User的静态已知属性(如性别),User_V表示User动态的已知属性(已经发生的行为),User_U表示User无法获取的属性,Item_S表示item静态的已知属性,Item_V表示item动态的已知属性,Item_U表示item无法获取的属性。

根据这个多维度模型,可以对目前一些常用的推荐算法进行统一,如图13所示。

图13 常用推荐算法的统一

多维度下的算法设计

1、学习User和Item的各维度的特征

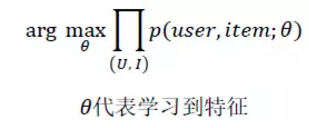

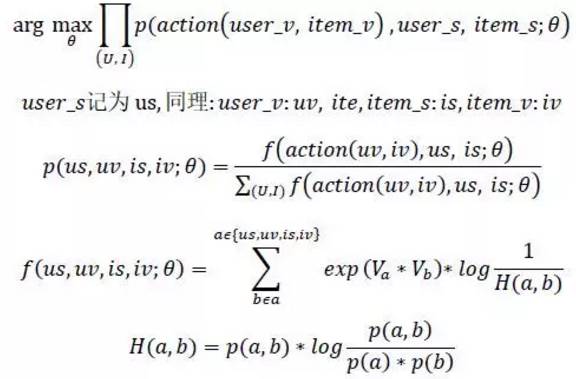

这个过程本质上是在数据集上寻找规律,用以描述整体数据的特性。所使用的数据包括User画像数据,Item画像数据以及相互之间的行为数据。User和Item直接的规律可以表示为:

不考虑不可知项,动态属性且只考虑User和Item之间的行为,记为action(user, item)

通过上述,可以学习到action(uv,iv),us, is的特征表示。

2、对User进行建模

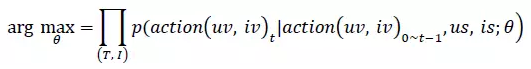

描述动态个体数据,根据规律获取对User在不同算法下的推荐结果。单用户时序序列建模,去学习每个人各个时刻的uv,iv。

基于之前学习到的uv,iv表达,使用时间序列针对每个用户进行建模,得到每个用户在任意时刻的表达,用于下一时刻推荐,模型采用浅层RNN网络。

3、排序和过滤

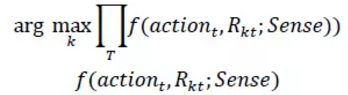

学习User对不同算法的推荐结果的偏好程度。

排序算法

-

为每组推荐结果进行标记,记为R_k,表示第k个推荐结果。

-

统计在不同的推荐场景下,各个时刻的用户行为和推荐结果的一致性,得到用户对算法的偏好(Learn To Rank)。

衡量在场景Sense下,t时刻,user行为和第k个算法推荐结果的一致性。这里简要说明,对于推荐的排序要考虑场景的必要性。以某电商推荐为例,流式推荐用户的意图相比于进入详情页或加入购物车的场景中的意图要弱,所以侧重多样性的推荐会更加合理;进入详情页后应侧重相似推荐,而购物车页面则应该侧重搭配推荐。

-

根据计算出来用户对推荐算法的得分,对推荐结果进行加权组合。

-

根据设定的过滤规则对结果进行过滤,包括已下架、性别过滤等过滤规则。

效果展示

总结

本文简单介绍了笔者在深度学习方面的一些实践工作以及一些认识。目前,几乎所有的机器学习方法,包括深度学习,本质上都是在统计数据,从中归纳出模型。深度学习只是采用了更加深层次的神经网络,以表达更加复杂的规律,或者对处理的对象进行表示。深度学习对于图像处理领域提供了一种有效的对空间进行结构化方式(CNNs),同理对于推荐系统领域则是对时序序列进行了有效的表示(RNNs)。值得注意的是,无论对空间和时序的表示,其实都是不充分的。目前的深度学习也仅仅对对象的某一方面进行表示,它无法对对象进行完整的描述。再者,空间和时序在进行处理的时候都存在局部性或截断问题,导致即使对这一方面的表示也是存在近似的。所以,机器学习、深度学习要实现真正的智能或理解依旧需要很多的工作。

参考文献:

[1] Sun Y, Wang X, Tang X. Deep learning face representation from predicting 10,000 classes[C]//Computer Vision and Pattern Recognition (CVPR), 2014 IEEE Conference on. IEEE, 2014: 1891-1898.

作者:祁斌川,网易杭州研究院数据挖掘部

责编:何永灿,欢迎人工智能领域技术投稿、约稿、给文章纠错,请发送邮件至heyc@csdn.net

本文为网易云公众号投稿,授权CSDN发布。

【CSDN_AI】热衷分享

博客地址:http://blog.yoqi.me/?p=2813

这篇文章还没有评论